Inteligencia Artificial (AI), Aprendizaje Automático (ML), y Aprendizaje Profundo (DL) son más que una simple llamarada para un stand de exposición. Las empresas están transformando sus prácticas empresariales, impulsando la productividad y creando nuevas oportunidades con el poder de los datos y la inteligencia artificial. Ante la escasez de recursos, las organizaciones deben decidir si desean ampliar o no sus procesos de IA. Esta decisión clave permitirá aprovechar mejor el talento de los científicos de datos de una organización, capturando eficiencias operativas, transformando la toma de decisiones y ofreciendo resultados empresariales más sólidos.

Entonces, ¿qué son la AI, el ML y la DL, y cómo se relacionan? DL es un subconjunto de ML, y ML es un subconjunto de AI – claro como el agua, ¿verdad? La IA puede sentir, razonar, actuar y adaptarse independientemente. ML y DL usan algoritmos matemáticos para `aprender’ en lugar de que se les diga explícitamente qué hacer como en los sistemas expertos (programación imperativa usando mucho `si, entonces si no’). Las técnicas ML utilizan una variedad de algoritmos para crear modelos matemáticos que pueden ser utilizados para predecir un resultado basado en una nueva entrada. DL estructura los algoritmos en capas para crear una «red neuronal» artificial que puede aprender y mejorar con grandes cantidades de datos para obtener una mejor salida (una decisión) basada en alguna nueva entrada.

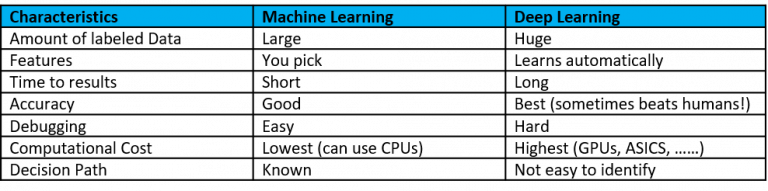

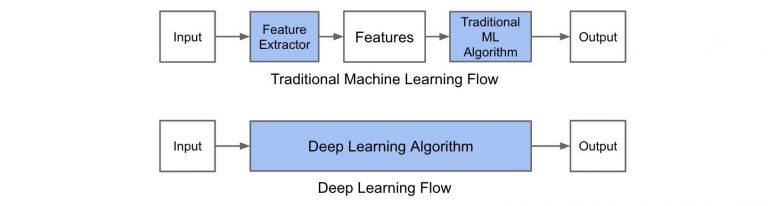

A continuación se muestran algunas características de ML y DL en las Figuras 1 y 2:

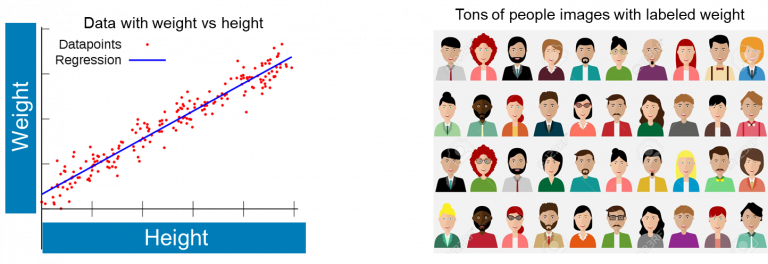

Como ejemplo de ML y DL, piense en el problema de predecir el peso de alguien (Figura 3). Podría ser un simple conjunto de datos con la altura y el peso, entonces, utilizando ML, se llega a la línea de mejor ajuste. Por el contrario, podría tener toneladas de datos de imagen etiquetados con peso, entonces DL podría refinar el modelo con muchas más consideraciones, tales como los rasgos faciales, mejorando así la precisión.

El combustible de la IA son muchos datos, modelos avanzados, algoritmos y software, e infraestructura de alto rendimiento. Como regla general, si usted es afortunado y tiene los tres combustibles, su organización debe usar DL. Si usted tiene dos de cada tres, uno, o ninguno, use ML.

El viaje de la IA es un reto. Cuando hablamos con nuestros clientes, ellos mencionan una experiencia limitada, una gestión inadecuada de los datos y presupuestos limitados. Su reto empresarial es triple: Definir, desarrollar e implementar. Deben definir los casos de uso, requisitos, objetivos de negocio para la inteligencia artificial. Luego, deben desarrollar las fuentes de datos, la infraestructura, los modelos entrenados y el proceso de refinamiento que rodea a un sistema de IA. Finalmente, necesitan desplegar los sistemas habilitados para la IA con herramientas de seguimiento e inferencia, a escala.

Ahora que hemos cubierto los desafíos aparentemente desalentadores de la implementación de la IA, vamos a sumergirnos en el tema optimista de una estrategia de scaling-up o scaling-out para la IA. La ampliación implica añadir más recursos a un sistema existente. En el caso de la IA, esto significa cuántos elementos de arquitectura específicos del dominio (DSA) hay en un servidor individual. DSA se está convirtiendo en el nombre de código que significa cualquier cosa que acelere más allá del cálculo de propósito general, como GPUs, ASICs, FPGAs, IPUs, etc. Sin embargo, la ampliación significa añadir más sistemas, cada uno con un cierto número de GPUs. Piense en esto en términos de servidor como un servidor de 32 sockets frente a un servidor de 2 sockets. Esto es como el argumento de hace más de 30 años del mainframe frente al escalamiento de x86. La economía a gran escala resultó ser la clara vencedora.

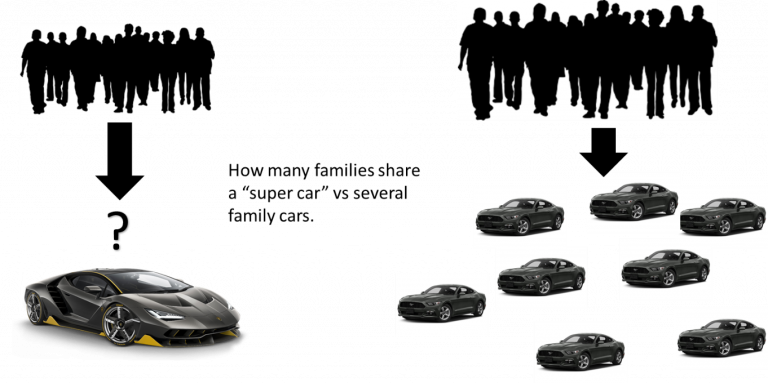

Por ejemplo, considere una familia con necesidades de transporte independientes. La familia podría comprar un Hennessy Venom GT – el coche más rápido del planeta – y uno por uno podrían compartirlo para satisfacer rápidamente sus necesidades de transporte. O bien, podrían comprar n número de autos de rendimiento suficiente y satisfacer todas sus necesidades todo el tiempo.

De la misma manera que la familia necesitará hacer viajes simultáneos, las corporaciones en el viaje de la IA necesitarán más de un científico de datos. Nuestro trabajo en tecnología es hacer que todos los científicos de datos sean productivos todo el tiempo.

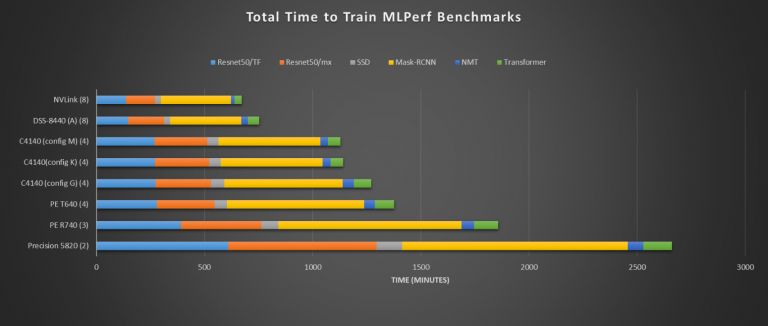

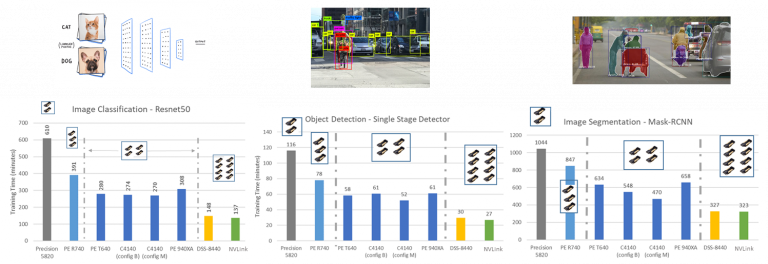

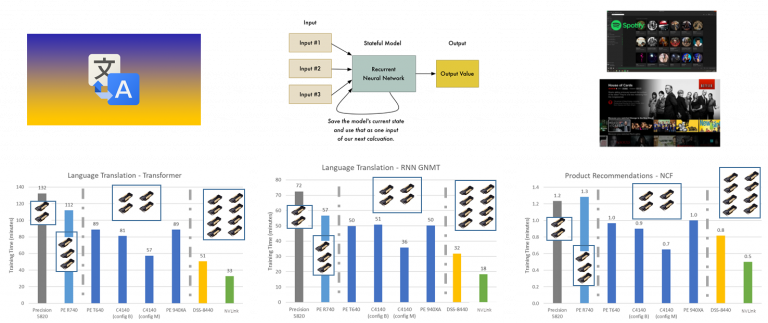

El primer conjunto de datos a continuación utiliza MLperf (MLperf construye puntos de referencia justos y útiles para medir la capacitación y el rendimiento de inferencia del hardware, software y servicios de ML) en todo el portafolio de servidores habilitados para arquitectura específica de dominio (DSA) de Dell. En la Figura 5 se puede ver el escalado de 2 GPUs V100 en el Precision 5820 a 4 V100 en un PowerEdge C4140 a 8 V100 en el DSS 8440 a 8 en un servidor habilitado para NVLink. El servidor 8-NVLink funciona ligeramente mejor que el DSS8440 habilitado para 8-PCI (tenga en cuenta que el DSS8440 puede soportar diez V100).

Si observa más de cerca las puntuaciones individuales de 8-GPU que aparecen a continuación en las dos figuras siguientes, las puntuaciones son muy similares, con excepción de la traducción y la recomendación para los dos casos diferentes de 8-GPU. Dicho esto, la brecha de rendimiento se ha cerrado entre NVLink y PCIe con las topologías PCIe adecuadas y un mejor soporte peer-to-peer para el conmutador PCIe, y se cerrará más con las velocidades de datos PCI de Gen4 y Gen5, que son 16GT/s y 32GT/s respectivamente, frente a Gen3, que era de 8GT/s.

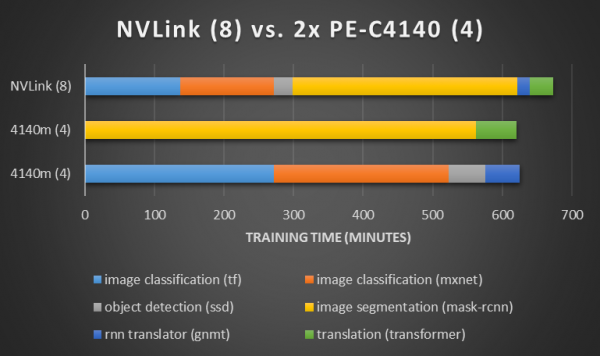

Si tomamos el mismo MLPerf, comparamos un servidor 8-NVLink con 2 servidores NVLink de 4 nodos, y extendemos los puntos de referencia a través de los dos servidores, ahora podemos hacer todo el trabajo más rápido que un único servidor 8-NVLink (Figura 8)

.

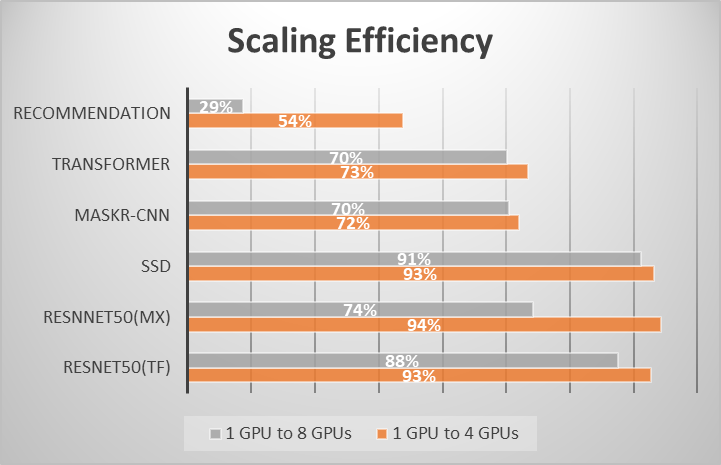

Esto se comprueba porque, según la ley de Amdahl, la aceleración no es lineal en el paralelismo a gran escala. Por lo tanto, es importante elegir un punto en la escala de aceleración antes de que llegue a la región no lineal y permanecer en el punto dulce económico de la escala. La Figura 9 muestra el escalado de las GPUs 1 a 4 y 1 a 8. Como puedes ver, el escalado de la GPU 1 a 4 tiene una mayor eficiencia en toda la placa (Figura 9).

Mark Twain popularizó el dicho: «Hay mentiras, malditas mentiras y estadísticas.». Si todavía fuera un periodista en el Área de la Bahía hoy en día, él dirigiría nuestra atención hacia las trampas de los puntos de referencia. Los puntos de referencia en el contexto correcto están bien, pero reducidos a métricas simples, los puntos de referencia pueden causar serios problemas. Los líderes deben entender los impulsores subyacentes de los puntos de referencia para tomar decisiones informadas. Continuando con nuestra escala o en el ejemplo, 2x nodos de escala superan el rendimiento de un solo nodo de escala superior usando MLperf, el mejor punto de referencia de la industria. La escala de salida C4140 es también la mejor opción de MLperf por dólar para la IA, que refleja el punto de optimización del uso de nodos de salida de escala económica. Además, si lo notó en las noticias, VMware anunció recientemente la adquisición de Bitfusion, que es un enfoque a gran escala de la infraestructura de inteligencia artificial elástica.

Ahora bien, esto no quiere decir que 8 sistemas GPU+ no tengan su lugar, al igual que nosotros tenemos servidores x86 de 8 a 32 sockets, tienen su lugar y su necesidad. Pero hay una ley económica y una ley Amdahl en juego que sugieren que la economía del escalamiento gana, excepto en los casos de esquina. El escalado de las GPUs se ve afectado por dos variables principales: el tamaño de los datos y el código optimizado. Si el conjunto de datos es demasiado pequeño y el escalado es ineficiente con más GPUs, terminas barajando los parámetros entre las GPUs más que haciendo cálculos en los datos. La mayoría de los modelos y casos de uso en la práctica para la DL en las empresas se ejecutarán mejor en una GPU debido al tamaño de los conjuntos de datos y a la calidad del código. Las empresas competentes en IA han contratado a programadores «ninja» cualificados debido a que utilizan casos o conjuntos de datos que requieren formación en más de 8 GPUs para cumplir los requisitos de tiempo de resolución. A todos los demás, buena suerte con la obtención de un mejor rendimiento en dos o más GPUs que en una sola GPU.

El hecho es que las empresas en un viaje de IA tendrán decenas o cientos de científicos de datos, no sólo uno. Nuestro trabajo en tecnología es asegurarnos de que todos los científicos de datos sean lo más productivos posible. Si una científica de datos termina su trabajo rápidamente mientras las otras están tomando café y esperando su turno, la compañía no es productiva. Al igual que comprar un superdeportivo para compartir con su cónyuge, sólo una persona puede ser feliz a la vez. Como escribió sabiamente el monje y poeta John Lydgate: «Puedes complacer a algunas personas todo el tiempo, puedes complacer a todas las personas algunas veces, pero no puedes complacer a todas las personas todo el tiempo». Bueno, en este caso, puedes hacer que todos los científicos de datos estén contentos todo el tiempo, permitiendo la productividad a todos, todo el tiempo, invirtiendo en la escalabilidad y en la orquestación adecuada de la carga de trabajo de la GPU.

Quiero agradecer a Ramesh Radhakrishnan, Ingeniero Distinguido de la Oficina de Sistemas de Infraestructura y Servidores CTO de Dell EMC, por el gran trabajo realizado en estos puntos de referencia.

Si tiene preguntas, desea profundizar o desea comprender la familia de servidores habilitados para DSA de Dell EMC, póngase en contacto con uno de nuestros amables representantes de ventas de Dell EMC. Para más reflexiones sobre este y otros temas, por favor síganme en LinkedIn.

Para obtener más información sobre las pruebas de rendimiento en servidores Dell PowerEdge relacionados con el aprendizaje en máquina y el aprendizaje profundo, visite hpcatdell.com.

Para obtener más información sobre los servidores PowerEdge, incluyendo el C4140 y el DSS 8440, visite dellemc.com/servers, o únase a la conversación en Twitter @DellEMCservers.