L’esecuzione delle applicazioni su server fisici ha presto manifestato alcuni limiti oggettivi, come la possibilità di definire con precisione l’allocazione delle risorse infrastruttuturali per le esigenze diverse di più applicativi. Venne così l’era della virtualizzazione, che permette di gestire più macchine virtuali su una singola CPU di un singolo server fisico. In questo contesto, la virtualizzazione consente alle applicazioni di essere isolate tra le macchine virtuali e fornisce un livello di sicurezza poiché le informazioni di un’applicazione non sono accessibili liberamente da un’altra applicazione.

La virtualizzazione, diffusissima, è una tecnologia che viene data per assodata. Ora, la necessità delle moderne aziende si è spostata sul rendere le proprie applicazioni “Cloud Native”, ovvero sempre più agili e in linea con le esigenze mutevoli del business. Per poter fare questo, deve essere prima definita una modalità di sviluppo a microservizi, ovvero un modello che permetta di sviluppare velocemente applicazioni agili e di poterle spostare automaticamente tra diversi ambienti Cloud, sia pubblici che privati. A questo punto entrano in gioco i cointainers, ovvero i “mattoncini” all’interno dei quali vengono sviluppati i microservizi. I containers sono paragonabili a delle macchine virtuali ma hanno proprietà di isolamento e accesso alle informazioni ben diverse, poichè hanno in condivisione il sistema operativo. Ogni containers ha il proprio filesystem, CPU, memoria e spazio di processo.

Quali i benefici dei containers? La creazione di applicazioni agili, il loro sviluppo continuo in uno spazio coerente e definito, la gestione application-centric, l’allocazione efficiente e l’isolamento delle risorse, sono tra i vantaggi principali dell’utilizzo dei containers.

Il limite maggiore? Se un container cade, è necessario avviarne un altro. Ma è proprio qui che entra in gioco Kubernetes, una piattaforma open-source estensibile per la gestione di carichi di lavoro e servizi “containerizzati”. Kubernetes ti fornisce un framework per eseguire in maniera resiliente i sistemi distribuiti, si occupa del ridimensionamento e del failover per le applicazioni e fornisce modelli di distribuzione.

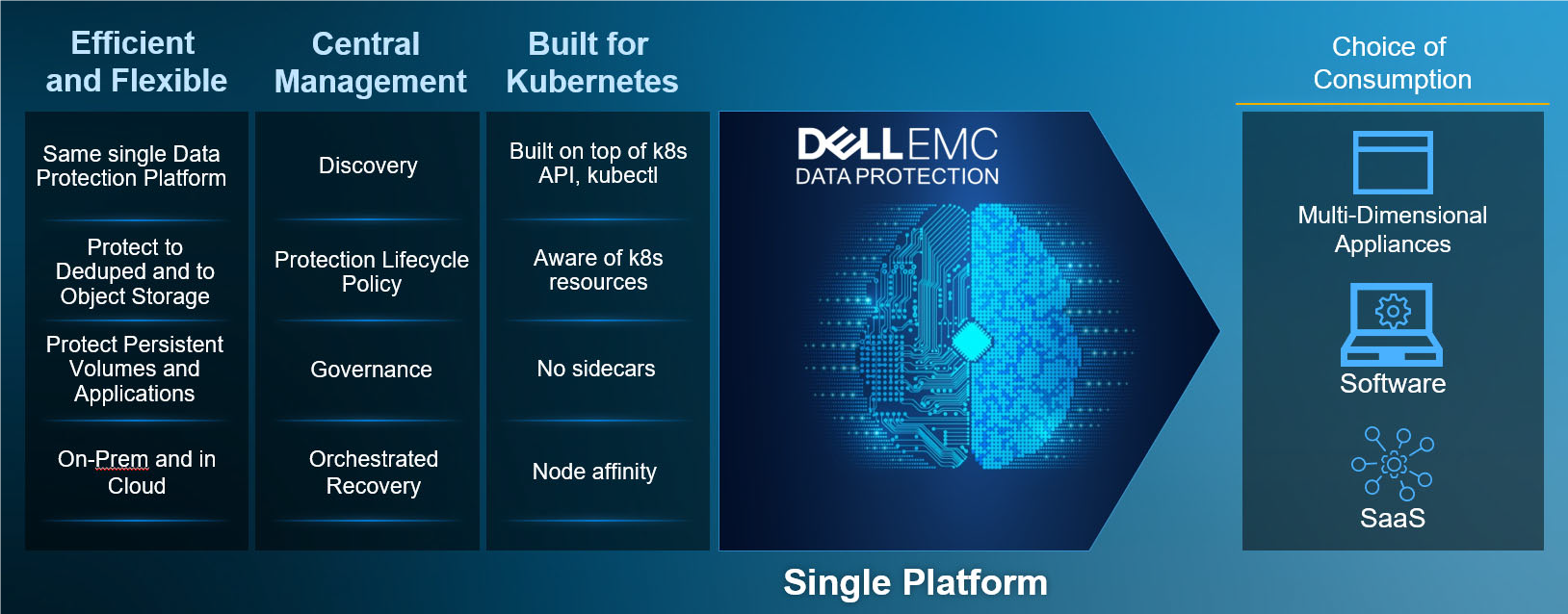

Con l’attuale modello di deployment risulta però necessario proteggere i workload e occuparsi della data protection dei dati persistenti. Primi ad affrontare il tema sul mercato, Dell Technologies con la soluzione PowerProtect Data Manger (PPDM) consente di proteggere i carichi di lavoro di produzione negli ambienti Kubernetes (K8s), garantendo che i dati persistenti siano facili da backuppare e ripristinare, sempre disponibili, coerenti e durevoli in un carico di lavoro Kubernetes o in una situazione di DR.

PowerProtect Data Manager (PPDM), i benefici:

- Facile da usare, è separato dall’ambiente di sviluppo; consente una governance centralizzata dall’ambiente di sviluppo;

- Gli utenti che utilizzano Data Domain beneficiano di un secondary storage con un efficienza, deduplica, prestazioni e scalabilità senza eguali;

- Il software PowerProtect offre gestione centralizzata, automazione, opzioni multi-cloud e integrazione VMware avanzata per semplificare e semplificare la gestione dei carichi di lavoro.

Link utili:

- Dell EMC Data Protection e VMware: https://www.delltechnologies.com/it-it/data-protection/protection-vmware.htm

- Dell EMC PowerProtect Data Manager: https://www.delltechnologies.com/en-us/data-protection/powerprotect-data-manager.htm

- Come funziona Kubernetes: https://kube.academy/

- Come configurare un cluster Kubernetes: https://kubernetes.io/docs/setup/