Część pierwsza.

Antropomorfizacja lub antropomorfizm to zabieg językowy, polegający na nadawaniu niebędącymi ludźmi przedmiotom, pojęciom, zjawiskom, zwierzętom itp. cech ludzkich i ludzkich motywów postępowania (https://pl.wikipedia.org/wiki/Antropomorfizacja).

Jeśli interesują Was nowe technologie i aktualne trendy w IT (i nie tylko) to, prawdopodobnie, wasz codzienny przegląd informacji obfituje w pozycje na temat kolejnego użycia sztucznej inteligencji w nowej dziedzinie życia lub kolejnego rozwiązania, które próbuje wzbogacić istniejące funkcjonalności przez magiczny dopisek, „używa Artificial intelligence (AI) lub Machine Learning (ML)”.

Nie zastanawiało was nigdy, dlaczego nie widzimy informacji „Zupełnie nowe zastosowanie Baz Danych” albo „nowa ulepszona wersja czajnika używająca bazy danych”. Mało osób zdaje sobie sprawę, że bazy danych są nowszą technologią od sztucznej inteligencji. Pierwsze użycie terminu i koncepcji baz danych to rok 1963 – natomiast sztuczna inteligencja to rok 1956

Długa historia sztucznej inteligencji

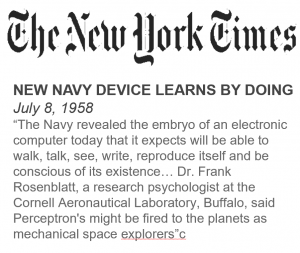

Skąd pochodzi nazwa „sztuczna inteligencja” – kilkadziesiąt lat temu tak właśnie wyobrażano sobie przyszłość komputerów i „inteligentnych” programów. Sam termin Sztuczna Inteligencja nie jest nowy – pojawił się po raz pierwszy już w 1956 roku i został wymyślony przez Johna McCarthyego (tego od języka LISP) i opisywał koncepcje programu, który potrafi się uczyć, rozumieć i być świadomym swojego istnienia.

Trzy lata wcześniej, w roku 1953, na pierwszym komercyjnie dostępnym komputerze – IBM 701, uruchomiono uczący się program – grający w warcaby. Był on na tyle dobry, że po krótkiej nauce pokonał ówczesnego mistrza stanowego.

Początki były trudne, ale idea myślących maszyn była niezwykle kusząca. W 1964 roku pojawia się ELIZA – pierwszy program, który oszukał człowieka nawiązując i podtrzymując rozsądną konwersacje. Oczywiście sama implementacja nie ma nic wspólnego z współczesnym NLP, ale miała niespodziewane konsekwencje – tak zwany efekt ELIZY, czyli przypisywania przez ludzi znaczenia i sensu znakom, słowom i zdaniom, które takiego sensu same z siebie nie mają. Sam program oparty był o zestaw reguł wyszukujących kluczowe słowa w wypowiedzi człowieka a następnie formułował odpowiedź zawierającą te same słowa z małymi dodatkami.

Przykładowo na pytanie:

„Czy jesteś człowiekiem” mógł dać odpowiedź: ” Być człowiekiem… czy to coś znaczy…”

Albo na pytanie „Co myślisz o mojej matce?” – dawał odpowiedź: „Nie znam twojej matki, opowiedz mi o niej coś więcej”.

Kolejne ciekawe i dużo bardziej praktyczne zastosowania to MCYIN (nazwa pochodzi od często stosowanego antybiotyku) – system ekspercki opracowany przez zespół Edwarda Shortliffe. Pan Edward (uważany za pioniera bioinformatyki) miał pomysł by komputer (nie używam liczby mnogiej, bo nie było ich aż tyle w latach 70) pomagał diagnozować choroby zakaźne na podstawie wyników badań krwi i wskazywał najlepszą kurację. Cel szczytny niestety ówczesna technologia, brak cyfrowych informacji i co najważniejsze brak globalnej sieci bardzo mocno ograniczyło potencjał tego pomysłu.

Co się stało później? Można powiedzieć, że wielkie nic. Doskonała koncepcja sztucznej inteligencji znika niemal całkowicie na prawie 30 lat.

Okres ten powszechnie nazywany jest zimą sztucznej inteligencji.

Gdy minął pierwszy zachwyt, okazało się, że technologia jeszcze nie jest gotowa na prawdziwe SI, a to, co było wtedy możliwe, to relatywnie proste systemy oparte o zestawy zależności i starające się jak najdokładniej opisać wszystkie możliwe scenariusze (np. system ekspercki MCYIN).

Jeśli coś jest zbyt skomplikowane – użyj statystyki

Dużo się zmieniło wraz z nowym podejściem do projektowania SI. Twórcy zamiast opisywać dokładnie każdą możliwość odkopali stare podręczniki do statystyki, a komputery dostały możliwość „uczenia się”.

Jak to stare? Przecież sztuczna inteligencja to nowa dziedzina techniki – no więc nie do końca. Przykładowo najbardziej klasyczny przykład nauczania maszynowego, czyli regresja liniowa została po raz pierwszy zastosowana już w 1866 roku.

Bardzo często programiści stosowali metody Machine Learning długo przed tym nim stało się to modne. Dobrym przykładem jest słynne twierdzenie Bayesa opublikowane w 1763 roku – które przez wiele lat stanowiło podstawę większości systemów katalogowania treści.

Rozpoznawanie spamu w systemach pocztowych polegało (i nadal bardzo często polega) na wskazaniu dobrych listów, które chcemy w naszej skrzynce oraz spamu, którego nie chcemy. Na tej podstawie używając twierdzenia Bayesa system uczył się/wyliczał odpowiednie prawdopodobieństwa i używał ich katalogując nowo przychodzące listy.

Odczarować sztuczną inteligencję.

Zastanówmy się teraz:

- Skoro technologia nie jest nowa, a wręcz przeciwnie pojawiła się wraz z pierwszymi komputerami.

- Algorytmy i metody stosowana w współczesnych implementacjach ML znane są od setek lat.

To co sprawia, że ta sztuczna inteligencja nadal traktowana jest jak czarna magia?

Dlaczego wszystkie nowe produkty muszą mieć w swoim opisie AI/ML albo przynajmniej projektowane z użyciem tych technologii?

O tym, dlaczego tak się dzieje i jak się nie dać zastraszyć, napiszę w kolejnej części, już niebawem.